您所在的位置:首页 - 热点 - 正文热点

hadoop编程模型

![]() 婉婕

2024-04-24

【热点】

263人已围观

婉婕

2024-04-24

【热点】

263人已围观

摘要ApacheHadoop是一个开源的分布式计算平台,用于存储和处理大规模数据集。Hadoop由分布式文件系统HDFS和分布式计算框架MapReduce组成,近年来已经逐渐发展为一个生态系统,包括各种相

Apache Hadoop是一个开源的分布式计算平台,用于存储和处理大规模数据集。Hadoop由分布式文件系统HDFS和分布式计算框架MapReduce组成,近年来已经逐渐发展为一个生态系统,包括各种相关项目和工具,如YARN、Hive、HBase等。在Hadoop技术编程领域,主要涉及HDFS的文件操作、MapReduce的编程模型、YARN的资源管理以及相关生态系统组件的使用。

1. HDFS文件操作

HDFS是Hadoop的底层文件系统,具有高容错性、高扩展性和高性能等特点。你可以通过Java API或命令行工具来操作HDFS上的文件,如上传、下载、删除、查看文件等。

示例代码:

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class HDFSExample {

public static void main(String[] args) {

try {

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path("input.txt");

Path destPath = new Path("hdfs://namenode:8020/user/hadoop/input/input.txt");

fs.copyFromLocalFile(srcPath, destPath);

fs.close();

} catch (Exception e) {

e.printStackTrace();

}

}

}

```

2. MapReduce编程模型

MapReduce是Hadoop提供的分布式计算框架,通过编写Map和Reduce两个阶段的程序来实现数据的处理和分析。在Map阶段,数据会被切分成小块,经过映射函数处理后生成键值对;在Reduce阶段,相同key的值会被合并处理,最终生成结果。

示例代码:

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCount {

public static class TokenizerMapper extends Mapper

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer extends Reducer

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable

int sum = 0;

for (IntWritable val : values) {

sum = val.get();

}

result.set(sum);

context.write(key, result);

}

}

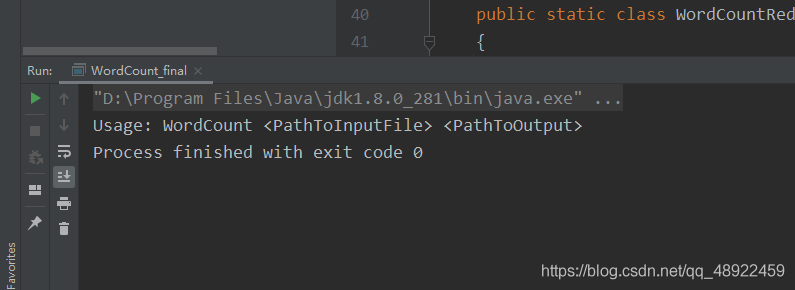

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

```

3. YARN资源管理

YARN(Yet Another Resource Negotiator)是Hadoop 2.0引入的资源管理器,负责集群资源的调度和任务的监控。在Hadoop应用中,YARN可以动态分配资源给不同的任务,有效地管理集群资源的利用。

4. 生态系统组件

除了HDFS、MapReduce和YARN外,Hadoop生态系统中还有许多其他组件可以扩展Hadoop的功能,如:

- Hive:用于数据仓库查询和分析的数据仓库工具。

- HBase:基于Hadoop的分布式列存储数据库。

- Spark:快速通用的集群计算系统。

- Sqoop:用于在Hadoop和结构化数据存储(如关系型数据库)之间传输数据的工具。

以上是对Hadoop技术编程的简要介绍,希望可以帮助你更好地理解和应用Hadoop在大数据处理方面的能力。

版权声明: 免责声明:本网站部分内容由用户自行上传,若侵犯了您的权益,请联系我们处理,谢谢!联系QQ:2760375052

上一篇: 编程手机版下载

最近发表

- 特朗普回应普京涉乌言论,强硬立场引发争议与担忧

- 民营企业如何向新而行——探索创新发展的路径与实践

- 联合国秘书长视角下的普京提议,深度解析与理解

- 广东茂名发生地震,一次轻微震动带来的启示与思考

- 刀郎演唱会外,上千歌迷的守候与共鸣

- 东北夫妻开店遭遇刁难?当地回应来了

- 特朗普惊人言论,为夺取格陵兰岛,美国不排除动用武力

- 超级食物在中国,掀起健康热潮

- 父爱无声胜有声,监控摄像头背后的温情呼唤

- 泥坑中的拥抱,一次意外的冒险之旅

- 成品油需求变天,市场趋势下的新机遇与挑战

- 警惕儿童健康隐患,10岁女孩因高烧去世背后的警示

- 提振消费,新举措助力消费复苏

- 蒙牛净利润暴跌98%的背后原因及未来展望

- 揭秘缅甸强震背后的真相,并非意外事件

- 揭秘失踪的清华毕业生罗生门背后的悲剧真相

- 冷空气终于要走了,春天的脚步近了

- 李乃文的神奇之笔,与和伟的奇妙转变

- 妹妹发现植物人哥哥离世后的崩溃大哭,生命的脆弱与情感的冲击

- 云南曲靖市会泽县发生4.4级地震,深入了解与应对之道

- 缅甸政府部门大楼倒塌事件,多名官员伤亡,揭示背后的故事

- 多方合力寻找失踪的十二岁少女,七天生死大搜寻

- S妈情绪崩溃,小S拒绝好友聚会背后的故事

- 缅甸遭遇地震,灾难之下的人间故事与影响深度解析

- 缅甸地震与瑞丽市中心高楼砖石坠落事件揭秘

- 揭秘ASP集中营,技术成长的摇篮与挑战

- 徐彬,整场高位压迫对海港形成巨大压力——战术分析与实践洞察

- ThreadX操作系统,轻量、高效与未来的嵌入式开发新选择

- 王钰栋脚踝被踩事件回应,伤势并不严重,一切都在恢复中

- 刘亦菲,粉色花瓣裙美神降临

- 三星W2018与G9298,高端翻盖手机的对比分析

- 多哈世乒赛器材,赛场内外的热议焦点

- K2两厢车,小巧灵活的城市出行神器,适合你的生活吗?

- 国家市监局将审查李嘉诚港口交易,聚焦市场关注焦点

- 提升知识水平的趣味之旅

- 清明五一档电影市场繁荣,多部影片争相上映,你期待哪一部?

- 美联储再次面临痛苦抉择,权衡通胀与经济恢复

- 家庭千万别买投影仪——真相大揭秘!

- 文物当上网红后,年轻人的创意与传承之道

- 手机解除Root的最简单方法,安全、快速、易操作

- 缅甸地震与汶川地震,能量的震撼与对比

- 2011款奥迪A8,豪华与科技的完美结合

- 广州惊艳亮相,可折叠电动垂直起降飞行器革新城市交通方式

- 比亚迪F3最低报价解析,性价比之选的购车指南

- 商业健康保险药品征求意见,行业内外视角与实用建议

- 官方动态解读,最低工资标准的合理调整

- 东风标致5008最新报价出炉,性价比杀手来了!

- 大陆配偶在台湾遭遇限期离台风波,各界发声背后的故事与影响

- 奔驰C级2022新款,豪华与科技的完美融合

- 大摩小摩去年四季度对A股的投资热潮